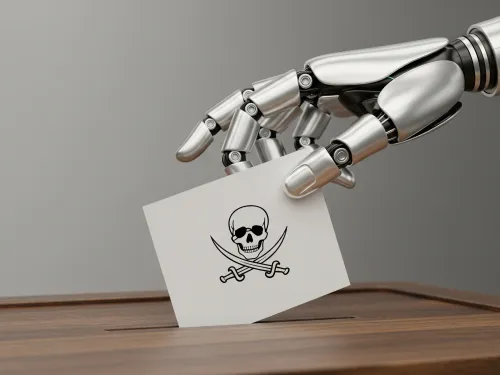

Introdução - A Nova Fronteira da Batalha Eleitoral

O ano de 2024 ficou marcado na história como o "super ano eleitoral", um período em que mais de dois bilhões de eleitores, em pelo menos 50 países, foram às urnas para decidir o futuro de suas nações.

Este artigo se propõe a aprofundar essa constatação, argumentando que, embora os temores iniciais de que a IA pudesse, por si só, "virar" eleições possam ser, por enquanto, exagerados, seu verdadeiro impacto é muito mais insidioso e sistêmico.

Para compreender plenamente este novo campo de batalha, este relatório irá desmistificar as tecnologias que compõem o arsenal da desinformação digital, desde a IA generativa e os deepfakes até as táticas invisíveis de microdirecionamento e redes de robôs. Em seguida, exploraremos estudos de caso de eleições ao redor do mundo, analisando como essas ferramentas foram utilizadas para assassinar reputações, suprimir votos e fabricar narrativas. Investigaremos o que os dados realmente dizem sobre o impacto da IA, separando o pânico moral da corrosão real e silenciosa da confiança democrática. Por fim, detalharemos as multifacetadas linhas de defesa que estão sendo erguidas — por governos, empresas de tecnologia e, crucialmente, pelos próprios cidadãos — para proteger a integridade do processo democrático na era da inteligência artificial.

Desmistificando a Caixa-Preta: O Arsenal da Desinformação Digital

Para entender a ameaça, é fundamental primeiro entender as ferramentas. A complexidade da inteligência artificial pode parecer intimidante, mas os conceitos por trás de seu uso na desinformação são acessíveis. Esta seção se dedica a abrir a "caixa-preta" tecnológica, explicando de forma didática o arsenal que está redefinindo as campanhas políticas.

O que é Inteligência Artificial Generativa?

No centro desta revolução está a Inteligência Artificial Generativa (IA Generativa). Diferente das IAs tradicionais, que são projetadas para analisar dados e fazer previsões ou classificações, a IA Generativa é treinada para criar conteúdo totalmente novo e original.

Esses sistemas são alimentados com quantidades massivas de dados — textos, imagens, áudios, vídeos e códigos de programação — e aprendem os padrões e as estruturas subjacentes a esses dados. Com esse conhecimento, ferramentas como o ChatGPT podem gerar textos coerentes, o Midjourney pode criar imagens fotorrealistas a partir de uma simples descrição, e o DALL-E pode produzir obras de arte em qualquer estilo imaginável.

Deepfakes: Quando Ver Não é Mais Crer

Um dos produtos mais notórios e preocupantes da IA Generativa são os deepfakes. O termo, uma junção de deep learning (aprendizagem profunda) e fake (falso), refere-se a mídias de áudio, vídeo ou imagem hiper-realistas que foram manipuladas ou inteiramente criadas por IA para mostrar pessoas dizendo ou fazendo coisas que nunca disseram ou fizeram.

A tecnologia por trás dos deepfakes mais convincentes é frequentemente uma Rede Generativa Adversária (GAN, na sigla em inglês). O conceito, embora complexo na prática, pode ser entendido como uma competição entre duas IAs.

- O Gerador (O Falsificador): Esta IA tem a tarefa de criar o conteúdo falso, como um vídeo de um político fazendo um discurso fictício.

- O Discriminador (O Detetive): Esta segunda IA é treinada com dados reais e sua única função é identificar se o conteúdo apresentado pelo Gerador é real ou falso.

No início, as criações do Falsificador são amadoras e facilmente detectadas pelo Detetive. No entanto, a cada falha, o Falsificador aprende e aprimora sua técnica. Esse ciclo de criação e detecção se repete milhões de vezes, com o Falsificador se tornando cada vez mais sofisticado para enganar o Detetive. O resultado final é um conteúdo falso de altíssima qualidade, muitas vezes indistinguível do real para o olho humano.

As Armas "Invisíveis": Microtargeting e Exércitos de Robôs

Além da criação de conteúdo falso, a IA opera de formas mais sutis e "invisíveis" para influenciar o eleitorado. Duas táticas se destacam: o microdirecionamento e o uso de redes de robôs.

O microdirecionamento (ou microtargeting) pode ser descrito como o "rifle de precisão" da propaganda política. Utilizando algoritmos de IA para analisar gigantescos volumes de dados (Big Data) coletados de nossas atividades online — curtidas em redes sociais, histórico de compras, buscas na internet, geolocalização — as campanhas constroem perfis psicológicos detalhados de cada eleitor.

clusters de pessoas com interesses, medos e valores semelhantes.

As redes de robôs (ou bot networks) funcionam como um "megafone" ou um "exército fantasma" para essas mensagens.

bots, são programadas para imitar o comportamento humano e amplificar massivamente certas narrativas através de postagens, curtidas e retuítes coordenados.

O verdadeiro perigo deste arsenal não reside no uso isolado de cada ferramenta, mas na sua combinação sinérgica. Uma campanha maliciosa pode, por exemplo, utilizar o microdirecionamento para identificar um grupo de eleitores indecisos e ansiosos com a economia.

deepfake de áudio convincente de um candidato adversário "confessando" um plano para aumentar impostos.

O Campo de Batalha Global: A IA em Ação nas Eleições Mundiais

A transição da teoria para a prática foi rápida e global. As ferramentas do arsenal de desinformação digital não são mais experimentais; elas foram ativamente implantadas em processos eleitorais em todos os continentes, demonstrando sua flexibilidade e potência para diferentes objetivos estratégicos. Esta seção analisa casos concretos que ilustram as táticas em ação e os atores geopolíticos por trás delas.

Estudos de Caso: Táticas de Manipulação em Ação

As campanhas de desinformação impulsionadas por IA adotaram diversas formas, cada uma visando explorar uma vulnerabilidade específica do ecossistema informacional e da psicologia do eleitor.

Assassinato de Reputação: Uma das táticas mais diretas é a destruição da credibilidade de um candidato através de "provas" fabricadas. No Canadá, uma imagem gerada por IA mostrando o candidato a primeiro-ministro Mark Carney ao lado do criminoso sexual condenado Jeffrey Epstein foi disseminada na plataforma X, uma clara tentativa de associá-lo a um escândalo repulsivo.

17 deepfake de um candidato do partido liberal circulou nas redes sociais, no qual ele supostamente discutia planos para aumentar o preço do álcool e fraudar a eleição. Esse conteúdo pode ter contribuído para a vitória de seu oponente pró-Rússia.

17 - Fabricação de Narrativas e Apoios: A IA também é usada para construir narrativas, tanto positivas quanto negativas. Na Argentina, durante a acirrada eleição presidencial de 2023, as campanhas de Sergio Massa e Javier Milei usaram intensivamente a IA para criar imagens que retratavam seus candidatos como heróis carismáticos ou, inversamente, seus oponentes como figuras distópicas e perigosas, inspirando-se na estética da cultura pop e até da propaganda soviética.

13 - Exploração da Confiança na Mídia: Uma tática particularmente perversa envolve sequestrar a credibilidade de instituições de mídia confiáveis. No Reino Unido, um deepfake mostrava uma conhecida apresentadora da BBC, Sarah Campbell, anunciando falsamente que o primeiro-ministro Rishi Sunak estava promovendo uma plataforma de investimentos fraudulenta.

17

A proliferação desses incidentes revela uma assimetria fundamental no campo de batalha da informação. Criar e disseminar desinformação com IA é uma operação de baixo custo, rápida e escalável. Um único ator mal-intencionado, como o consultor político que confessou ter criado o robocall de Biden por apenas 150 dólares, pode gerar um caos que força todo um aparato estatal, ecossistemas de mídia e organizações da sociedade civil a entrarem em modo de defesa.

A Geopolítica da Desinformação: Os Atores por Trás das Sombras

Embora as ferramentas de IA estejam cada vez mais acessíveis, as operações de influência mais sofisticadas ainda estão ligadas a atores estatais que as utilizam como um componente central de sua estratégia de política externa.

- Rússia: Moscou tem sido um pioneiro no uso da IA como uma arma de guerra híbrida. O presidente Vladimir Putin declarou que a nação que liderar em IA se tornará "a senhora do mundo", e o Kremlin tem investido pesadamente para transformar essa visão em realidade.

21 bot farms para amplificar narrativas estatais, a Rússia desenvolveu ferramentas sofisticadas como o "Meliorator", um software baseado em IA projetado para produzir em massa personas online falsas, mas de aparência autêntica. Essas personas são implantadas em plataformas como o X (antigo Twitter) para inundar o espaço informacional com conteúdo direcionado, semear discórdia e manipular sutilmente a opinião pública internacional. 21 - China e Irã: Outros regimes autoritários também adotaram essas táticas. Investigações descobriram operações de influência ligadas ao Irã que utilizaram chatbots para gerar desinformação eleitoral nos EUA e criaram domínios de sites falsos que se passavam por veículos de notícias americanos para circular conteúdo divisivo.

1 deepfakes de IA, em uma tentativa de minar o processo democrático na ilha. 17 - A Resposta da OTAN: A crescente utilização da IA como arma por adversários geopolíticos é vista como uma ameaça direta à segurança das democracias ocidentais. A OTAN tem expressado grande preocupação, com seus membros pedindo ações decisivas para fortalecer a resiliência contra ciberataques e campanhas de desinformação orquestradas pela China e pela Rússia.

22 21

Impacto Real vs. Pânico Moral: O que os Dados Realmente Dizem?

Em meio a manchetes alarmantes e exemplos chocantes, é crucial dar um passo atrás e fazer uma análise sóbria do impacto real da inteligência artificial nas eleições. A narrativa de que a IA é uma força apocalíptica que pode, sozinha, derrubar democracias precisa ser confrontada com as evidências disponíveis. Esta seção busca separar o pânico moral do dano concreto e documentado, focando no que os dados e os especialistas realmente dizem.

O Veredito das Urnas: A IA Já Decidiu uma Eleição?

A pergunta mais premente é se uma campanha de desinformação baseada em IA já foi o fator decisivo para o resultado de uma eleição importante. A resposta, de acordo com as principais instituições de pesquisa que monitoram o fenômeno, é que atualmente não há evidências conclusivas de que isso tenha acontecido. Relatórios do Centro de Tecnologia Emergente e Segurança (CETaS) do Instituto Alan Turing, por exemplo, analisaram eleições chave em 2024, incluindo no Reino Unido, na União Europeia, em Taiwan e na Índia, e não encontraram provas de que a desinformação habilitada por IA tenha alterado mensuravelmente um resultado eleitoral.

No entanto, é fundamental entender a ressalva que acompanha essa conclusão. A ausência de evidência não é evidência de ausência. O principal motivo para essa incerteza é a enorme dificuldade metodológica em comprovar uma ligação causal direta entre a exposição a um conteúdo online e o comportamento de um eleitor na cabine de votação.

A Corrosão da Confiança: O Dano Real e Silencioso

Se o impacto direto nos resultados é incerto, onde reside então o verdadeiro perigo da IA nas eleições? A resposta está nos danos mais sutis e de longo prazo, na corrosão lenta e silenciosa dos pilares que sustentam uma democracia funcional: a confiança e a coesão social.

O principal dano documentado não é a conversão de votos, mas a degradação do discurso democrático. A IA atua de três maneiras principais:

- Moldando a Agenda Política: O conteúdo gerado por IA, especialmente quando viraliza, consegue moldar a pauta do debate público, forçando candidatos e a mídia a responderem a falsidades e a desviarem o foco de questões políticas substantivas.

1 - Aprofundando a Polarização: As pesquisas mostram que a desinformação raramente convence um adversário; em vez disso, ela é primariamente consumida e amplificada por aqueles que já possuem crenças alinhadas com a mensagem falsa. O conteúdo de IA serve como "combustível para o fogo", reforçando as convicções de cada lado, entrincheirando a polarização e tornando o diálogo e o compromisso entre grupos políticos praticamente impossíveis.

1 - Poluindo o Ecossistema Informacional: A facilidade com que a IA pode gerar conteúdo leva à proliferação do que alguns analistas chamam de "AI slop" — um dilúvio de conteúdo de baixa qualidade, repetitivo e muitas vezes sem sentido, que inunda as redes sociais. Esse "lixo" informacional torna cada vez mais difícil para o cidadão comum encontrar fontes de informação confiáveis, levando ao cinismo, à apatia e ao desligamento do processo político.

27

Esses efeitos, somados, criam um ciclo vicioso perigoso. À medida que a desinformação impulsionada pela IA corrói a confiança nas instituições tradicionais (mídia, governo, justiça eleitoral), a população se torna mais cínica e propensa a buscar informações em fontes alternativas e não verificadas.

O "Dividendo do Mentiroso": A Arma Mais Perigosa

Talvez a ameaça mais sofisticada e preocupante que emerge da proliferação da IA seja o que os especialistas chamam de "Dividendo do Mentiroso" (Liar's Dividend).

O mecanismo é simples e devastador: um político ou figura pública é flagrado em um vídeo ou áudio autêntico e incriminador. Em vez de assumir a responsabilidade, ele simplesmente alega que o material é um "deepfake". Como o público sabe que a tecnologia para criar falsificações convincentes existe, a dúvida é semeada. A negação plausível se torna mais fácil, e a verdade se torna apenas mais uma versão da história.

Este não é um risco hipotético. Já existem exemplos notáveis de seu uso. Em eleições recentes na Turquia, um candidato confrontado com um vídeo comprometedor alegou falsamente que se tratava de um deepfake, quando na verdade era real. Na Índia, um político tentou a mesma tática para desacreditar gravações de áudio autênticas em que ele criticava membros de seu próprio partido.

A consequência final do "Dividendo do Mentiroso" é a criação de um "cinismo generalizado sobre a verdade e as instituições encarregadas de descobri-la".

Seção 5: A Linha de Defesa: Como Proteger a Democracia na Era da IA

Diante de uma ameaça tão complexa e multifacetada, a resposta para proteger a integridade democrática também precisa ser diversificada e robusta. Não existe uma "bala de prata" capaz de resolver o problema da desinformação gerada por IA. A defesa eficaz requer uma abordagem em camadas, envolvendo soluções tecnológicas, marcos regulatórios e, fundamentalmente, o fortalecimento da capacidade crítica do cidadão.

Soluções Tecnológicas: A Promessa e os Perigos da "Bala de Prata"

A primeira linha de defesa que vem à mente é usar a própria tecnologia para combater seus maus usos. Duas abordagens principais têm ganhado destaque: a marca d'água digital e os detectores de conteúdo de IA.

A marca d'água digital (digital watermarking) consiste em embutir uma assinatura invisível e legível por máquina no conteúdo gerado por IA. Essa marca d'água funciona como um selo de autenticidade (ou, neste caso, de artificialidade), permitindo que plataformas e ferramentas identifiquem a origem do conteúdo.

Os detectores de conteúdo de IA, por sua vez, são algoritmos treinados para identificar os padrões estatísticos e as "impressões digitais" deixadas pelo texto ou imagens gerados por máquinas. Eles analisam características como a estrutura da frase, a repetitividade de palavras e outras sutilezas que podem diferenciar o conteúdo artificial do humano.

No entanto, é crucial entender as limitações críticas dessas soluções. Elas estão longe de serem infalíveis. Atores mal-intencionados podem desenvolver técnicas para remover ou degradar as marcas d'água.

Respostas Governamentais e Legais: Construindo as Barreiras

Reconhecendo que a tecnologia sozinha não é suficiente, governos ao redor do mundo começaram a construir arcabouços legais para mitigar os riscos da IA nas eleições. Três modelos principais se destacam:

- O Modelo Europeu: A União Europeia adotou a abordagem mais abrangente e proativa. Através de uma combinação do Digital Services Act (DSA) e do AI Act, a UE estabeleceu um modelo baseado em risco. O DSA responsabiliza as grandes plataformas online pelos riscos sistêmicos que seus serviços podem criar, incluindo a disseminação de desinformação.

20 deepfakes em propaganda política. 32 - O Modelo Americano: Em contraste com a abordagem centralizada da Europa, os Estados Unidos apresentam um cenário fragmentado. Não existe uma lei federal abrangente que regule o uso de IA em campanhas.

38 39 deepfakes enganosos nos dias que antecedem uma eleição; a maioria, como Califórnia e Flórida, opta por exigir um aviso claro de que o conteúdo foi gerado ou manipulado por IA. 39 - O Modelo Brasileiro: O Brasil desenvolveu um modelo único, liderado pelo Poder Judiciário. O Tribunal Superior Eleitoral (TSE) assumiu um papel proativo, emitindo resoluções que regulam o uso de IA nas eleições antes mesmo que o Congresso Nacional legislasse sobre o tema. Para as eleições municipais de 2024, por exemplo, o TSE proibiu o uso de deepfakes para criar conteúdo falso e exigiu que todo material de campanha que utilizasse IA para qualquer fim (mesmo para simples melhorias de imagem) contivesse um aviso explícito e visível sobre seu uso, responsabilizando as campanhas pela disseminação de conteúdo manipulado.

41

O Poder do Cidadão: Literacia Mediática e Verificação de Fatos

A linha de defesa mais resiliente e duradoura contra a desinformação não é tecnológica nem puramente legal, mas humana. Uma cidadania informada, crítica e cética é o antídoto mais eficaz para a manipulação. É aqui que entra a literacia mediática (media literacy).

Iniciativas ao redor do mundo têm demonstrado o poder da educação para construir resiliência. A Finlândia, por exemplo, que vive sob a constante ameaça da desinformação russa, integrou a literacia mediática e o pensamento crítico em seu currículo escolar básico, desde as séries iniciais. O resultado é uma população consistentemente classificada como a mais resistente da Europa aos efeitos de notícias falsas.

Para o cidadão comum, os princípios da literacia mediática podem ser resumidos em um conjunto de práticas simples, mas poderosas:

- Pause antes de compartilhar: Conteúdos que provocam emoções fortes (raiva, medo, euforia) são frequentemente projetados para contornar o pensamento crítico. A primeira reação deve ser a desconfiança.

- Verifique a fonte: Quem está por trás da informação? É uma organização de notícias respeitável ou um site desconhecido com um nome que parece vagamente familiar?

- Procure o contexto: Muitas vezes, a desinformação não é uma mentira completa, mas um fato verdadeiro tirado de contexto. Procure a história original. Uma imagem ou vídeo pode ser real, mas de um evento completamente diferente.

- Questione o propósito: Por que essa informação está sendo mostrada a você agora? Qual é o objetivo de quem a criou?

Para auxiliar nesse processo, uma série de ferramentas de verificação de fatos está disponível para o público.

| Tipo de Ferramenta | Exemplos e Descrição | Fontes |

|---|---|---|

| Verificação de Fatos (Geral) | PolitiFact: Focado em verificar declarações de políticos e figuras públicas nos EUA, usando um "Truth-O-Meter". FactCheck.org: Projeto não partidário que monitora a precisão de anúncios, debates e discursos políticos. Snopes: Um dos mais antigos sites de verificação, especializado em desmentir lendas urbanas, boatos e desinformação viral. Agências de Notícias (ex: AFP Checamos, Reuters Fact Check): Muitas grandes agências de notícias globais possuem divisões dedicadas à verificação de fatos. |

|

| Verificação de Imagens e Vídeos | TinEye: Permite fazer uma busca reversa de imagens para descobrir onde uma imagem apareceu pela primeira vez na internet e se foi alterada. Google Reverse Image Search: Semelhante ao TinEye, ajuda a rastrear a origem e o uso de uma imagem online. InVID WeVerify: Uma extensão de navegador projetada para ajudar jornalistas e pesquisadores a autenticar vídeos e imagens, detectando manipulações. |

|

| Extensões de Navegador e Ferramentas Úteis | Media Bias/Fact Check Extension: Uma extensão que, ao navegar em um site de notícias, exibe uma classificação de seu viés político e confiabilidade factual, com base nos dados do site mediabiasfactcheck.com. Pino - Fact Checker: Uma extensão que utiliza IA para verificar trechos de texto selecionados em qualquer página da web, fornecendo uma pontuação de precisão e fontes. |

|

Seção 6: O Futuro da Democracia: Desafios de Longo Prazo e a Batalha pela Confiança

A ascensão da inteligência artificial nas eleições transcende os ciclos eleitorais individuais. Ela apresenta um desafio estratégico e de longo prazo para a própria natureza da governança democrática. A batalha que se desenrola não é apenas sobre quem vence a próxima eleição, mas sobre se a própria ideia de um debate público baseado em fatos e confiança mútua pode sobreviver na era digital.

Ameaça à Segurança Nacional e a Estabilidade Global

Especialistas em segurança e organizações internacionais já não enquadram a desinformação impulsionada por IA como um mero problema político, mas como uma das mais graves ameaças à segurança nacional e à estabilidade global. O Fórum Econômico Mundial, em seu Relatório de Riscos Globais de 2024, classificou a desinformação gerada por IA como o risco mais severo que o mundo enfrenta no curto prazo, à frente de guerras, eventos climáticos extremos e instabilidade econômica.

A lógica por trás dessa avaliação é clara. Atores estatais adversários, como Rússia e China, utilizam essas tecnologias não apenas para favorecer um candidato, mas como uma forma de guerra híbrida para desestabilizar sociedades democráticas a partir de dentro.

A Batalha pela Realidade: O Impacto nos Pilares Democráticos

O impacto de longo prazo da IA se manifesta na erosão dos três pilares centrais da governança democrática: representação, responsabilização e confiança.

- Representação: A democracia representativa baseia-se na premissa de que os governantes podem ouvir e responder aos anseios de seus constituintes. No entanto, como um oficial eleito pode discernir o sentimento público genuíno quando o espaço digital está inundado por um volume massivo de "ruído" gerado por IA, incluindo campanhas de astroturfing e exércitos de robôs que simulam apoio ou oposição a certas políticas?

26 - Responsabilização (Accountability): A capacidade dos eleitores de fiscalizar e cobrar seus líderes é fundamental. O "Dividendo do Mentiroso" ataca diretamente esse pilar. Se qualquer evidência de má conduta, corrupção ou mentira pode ser descartada como um "deepfake", como os eleitores podem responsabilizar seus representantes por suas ações?.

18 - Confiança: A confiança é a moeda mais importante em qualquer sistema político. Confiança no processo eleitoral, confiança na mídia, confiança nas instituições e confiança mútua entre os cidadãos. A poluição sistemática do ecossistema informacional com conteúdo falso, manipulado e divisivo, corrói essa confiança em todas as frentes.

26

Alguns teóricos levantam a preocupação com o surgimento de uma "Algocracia", um sistema onde a dependência excessiva de algoritmos para a tomada de decisões públicas acaba por estruturar e limitar a participação humana, transferindo o poder de deliberação dos cidadãos para sistemas automatizados opacos.

Chamado à Ação: A Responsabilidade Coletiva na Defesa da Democracia

A conclusão inevitável é que a luta contra a desinformação na era da IA não é um esporte para espectadores. Não se trata de uma batalha que pode ser vencida apenas por governos, por empresas de tecnologia ou por especialistas. A defesa da democracia exige uma aliança e uma responsabilidade coletiva.

- Governos devem continuar a desenvolver regulações inteligentes e ágeis, que protejam os cidadãos sem sufocar a inovação ou a liberdade de expressão, aprendendo com os modelos implementados na Europa, nos EUA e no Brasil.

17 - Empresas de tecnologia têm a responsabilidade ética e comercial de projetar a segurança em seus produtos desde o início (safety by design), assumindo a responsabilidade pelas ferramentas que liberam no mundo e colaborando ativamente para mitigar seus danos.

31 - A sociedade civil e a imprensa devem manter seu papel vital de vigilância, investigando, expondo e explicando as táticas de manipulação para o público em geral.

- E, mais importante, os cidadãos são a linha de frente final. A resiliência de uma democracia é, em última análise, a soma da resiliência de seus cidadãos. Isso requer um compromisso contínuo com a educação, o pensamento crítico e a participação responsável no debate público.

A tecnologia continuará a evoluir, e as ameaças se tornarão mais sofisticadas. A defesa definitiva não reside em uma ferramenta ou em uma lei, mas em uma população engajada, que valoriza a verdade, exige responsabilidade e compreende que a liberdade de informação vem acompanhada do dever de verificação. A batalha pela democracia na era da IA será vencida ou perdida não nos servidores que geram os deepfakes, mas na mente de cada cidadão que escolhe clicar, acreditar e compartilhar.

Referências:

- https://www.youtube.com/watch?v=XvdtnvKPHJc

- https://www.wilsoncenter.org/blog-post/combating-disinformation-brazilian-judiciary-initiatives-2024-municipal-elections

- https://www.webpurify.com/blog/how-to-fact-check-free-tools/

- https://www.swissinfo.ch/por/suicos-do-estrangeiro/isabella-kocum-para-quem-tudo-que-brilha-e-ouro/89536094

- https://www.sydney.edu.au/news-opinion/news/2021/02/17/can-bots-influence-elections-with-the-megaphone-effect.html

- https://www.rand.org/research/projects/truth-decay/fighting-disinformation/search.html

- https://www.proofpoint.com/us/threat-reference/deepfake

- https://www.promarket.org/2025/06/27/brazils-efforts-to-address-election-disinformation-illustrate-the-difficulties-of-protecting-the-marketplace-of-ideas/

- https://www.poder360.com.br/poder-midia-hoje/

- https://www.pcmag.com/picks/dont-just-google-it-smarter-search-engines-to-try

- https://www.pahouse.com/Tarik/InTheNews/NewsRelease/?id=139139

- https://www.ncsl.org/elections-and-campaigns/artificial-intelligence-ai-in-elections-and-campaigns

- https://www.newamerica.org/oti/blog/demystifying-ai-ai-and-elections/

- https://www.mdpi.com/2813-5288/2/4/20

- https://www.journalofdemocracy.org/articles/how-ai-threatens-democracy/

- https://www.itu.int/hub/2024/05/ai-watermarking-a-watershed-for-multimedia-authenticity/

- https://www.ibm.com/think/topics/generative-ai

- https://www.house.mn.gov/sessiondaily/Story/18085

- https://www.heinz.cmu.edu/media/2024/October/voters-heres-how-to-spot-ai-deepfakes-that-spread-election-related-misinformation1

- https://www.gov.uk/government/publications/deepfakes-and-media-literacy/deepfakes-and-media-literacy

- https://www.gao.gov/assets/gao-20-379sp.pdf

- https://www.frontiersin.org/journals/artificial-intelligence/articles/10.3389/frai.2024.1474034/pdf

- https://www.eftsure.com/blog/industry-news/generative-ai/

- https://www.congress.gov/crs-product/IN12222

- https://www.chathamhouse.org/2025/06/natos-collective-defence-europe-must-lead-data-sharing

- https://www.cato.org/policy-analysis/misleading-panic-over-misinformation

- https://www.canada.ca/en/communications-security/news/2025/03/communications-security-establishment-canada-releases-2025-update-to-report-on-cyber-threats-to-canadas-democratic-process.html

- https://www.cambridge.org/core/journals/german-law-journal/article/european-constitutional-way-to-address-disinformation-in-the-age-of-artificial-intelligence/548C4C0592757ADC0D250EF8C4C3D434

- https://www.brennancenter.org/our-work/research-reports/how-detect-and-guard-against-deceptive-ai-generated-election-information

- https://www.brennancenter.org/our-work/analysis-opinion/effect-ai-elections-around-world-and-what-do-about-it

- https://www.brookings.edu/events/generative-ai-elections/

- https://www.brookings.edu/articles/when-it-comes-to-understanding-ais-impact-on-elections-were-still-working-in-the-dark/

- https://www.brookings.edu/articles/the-impact-of-generative-ai-in-a-global-election-year/

- https://www.brookings.edu/articles/detecting-ai-fingerprints-a-guide-to-watermarking-and-beyond/

- https://www.agazeta.com.br/mundo/muculmano-socialista-de-33-anos-que-defende-tarifa-zero-para-transporte-vira-favorito-para-ser-novo-prefeito-de-nova-york-0625

- https://sagamoreinstitute.org/media-literacy-case-studies/

- https://scholarship.law.umn.edu/cgi/viewcontent.cgi?article=1573&context=mjlst

- https://securityconference.org/en/publications/analyses/ai-pocalypse-disinformation-super-election-year/

- https://post.parliament.uk/ai-disinformation-and-cyber-security/

- https://open.clemson.edu/cgi/viewcontent.cgi?article=1006&context=mfh_reports

- https://narrato.io/blog/what-are-ai-content-detectors-and-how-to-outsmart-them/

- https://misinforeview.hks.harvard.edu/article/the-origin-of-public-concerns-over-ai-supercharging-misinformation-in-the-2024-u-s-presidential-election/

- https://libguides.lakeheadu.ca/c.php?g=699699&p=4967982

- https://library.csi.cuny.edu/misinformation/fact-checking-websites

- https://journalistsresource.org/home/how-ai-deepfakes-threaten-the-2024-elections/

- https://izooto.com/blog/top-5-reliable-fact-checking-tools-for-news-and-media-publishers

- https://isps.yale.edu/news/blog/2025/04/ai-and-democracy-scholars-unpack-the-intersection-of-technology-and-governance

- https://international.tse.jus.br/en/misinformation-and-fake-news/brazil-electoral-justice-permanent-program-on-countering-disinformation

- https://indigo.ai/en/blog/ai-democracy/

- https://huggingface.co/blog/watermarking

- https://guides.library.ttu.edu/artificialintelligencetools/detection

- https://georgetownsecuritystudiesreview.org/2024/03/26/fighting-fire-with-fire-u-s-and-uk-leadership-can-lead-natos-use-of-ai-to-defend-against-ai-disinformation/

- https://gdil.org/a-guided-tour-of-disinformation-policy-media-literacy/

- https://epd.eu/content/uploads/2024/09/AI-and-elections.pdf

- https://erau.libguides.com/fake-news/fact-checking

- https://en.wikipedia.org/wiki/Deepfake

- https://en.wikipedia.org/wiki/Artificial_intelligence_content_detection

- https://edmo.eu/blog/dismissing-disinformation-lessons-from-a-groundbreaking-digital-media-literacy-campaign/

- https://dfrlab.org/2024/11/26/brazil-election-ai-deepfakes/

- https://dialogopolitico.org/special-edition-2025-artificial-democracy/from-mass-networks-to-personalised-voting

- https://defense360.csis.org/combating-misinformation-through-media-literacy-education/

- https://crossplag.com/ai-content-detector/

- https://commission.europa.eu/topics/countering-information-manipulation_en

- https://cjel.law.columbia.edu/preliminary-reference/2024/deepfake-deep-trouble-the-european-ai-act-and-the-fight-against-ai-generated-misinformation/

- https://chromewebstore.google.com/detail/pino-fact-checker/olfaipihfeomkedngnkkmappbojmlmml

- https://cetas.turing.ac.uk/publications/ai-enabled-influence-operations-safeguarding-future-elections

- https://carnegieendowment.org/research/2024/12/can-democracy-survive-the-disruptive-power-of-ai

- https://br.investing.com/news/economy-news/setor-de-manufatura-arrasta-economia-do-canada-para-contracao-em-abril-1594151

- https://blog.flocabulary.com/news-media-literacy/

- https://bertie.ces.ncsu.edu/2025/03/digital-literacy-for-the-age-of-deepfakes-recognizing-misinformation-in-ai-generated-media/

- https://better-internet-for-kids.europa.eu/en/resource-directory/deepfakes-teaching-program-media-literacy

- https://better-internet-for-kids.europa.eu/en/news/rising-importance-disinformation-media-literacy

- https://babl.ai/the-impact-of-ai-on-democracy-elections-misinformation-and-what-we-can-do-about-it/

- https://ash.harvard.edu/articles/weaponized-ai-a-new-era-of-threats/

- https://apublica.org/2025/06/israel-x-ira-netanyahu-esperou-o-melhor-momento-para-atacar/

- https://apnews.com/article/ai-election-misinformation-voting-chatgpt-altman-openai-0e6b22568e90733ae1f89a0d54d64139

- https://saisreview.sais.jhu.edu/social-media-disinformation-and-ai-transforming-the-landscape-of-the-2024-u-s-presidential-political-campaigns/

- https://www.tandfonline.com/doi/full/10.1080/19331681.2025.2487085

- https://www.tandfonline.com/doi/full/10.1080/19331681.2025.2473994

- https://www.techpolicy.press/five-real-world-failures-expose-need-for-effective-detection-of-ai-generated-media/

- https://www.unit21.ai/fraud-aml-dictionary/deepfake

- https://www.citizen.org/news/25-states-enact-laws-to-regulate-election-deepfakes/

- https://www.datacamp.com/blog/ai-watermarking

- https://natoassociation.ca/weaponized-ai-the-new-frontline-in-global-disinformation-warfare/

- https://natoassociation.ca/ai-powered-mis-disinformation-war/

- https://news.emory.edu/features/2024/09/emag_ai_elections_25-09-2024/index.html

- https://news.microsoft.com/ai-deepfakes-elections/

- https://www.nato-pa.int/news/nato-assembly-calls-decisive-action-cyberattacks-and-disinformation-stronger-partnerships

Comentar